寒武纪:等待下一个爆发期

前几日,寒武纪在官网宣布推出第三代云端AI芯片思元370及搭载该芯片的MLU370-S4、MLU370-X4加速卡和全新升级的Cambricon Neuware软件栈等新品。没有华丽的发布会,没有炫彩的PPT,寒武纪发布新品的风格,依然是典型的朴素“理工男”特点。

在这个愈发重视AI芯片自主架构、能拥有“杀手级”应用场景、能实现算力突破与能耗双控的时代,思元370其实具有多项领先优势:

在架构上,思元370属于寒武纪第四代自研智能芯片架构,第一代架构MLUarch00主打智能加速IP核,第二代MLUarch01主打多核架构,第三代MLUarch02主打多核共享片内存储,第四代MLUarch03更是寒武纪首款采用 chiplet(芯粒)技术的AI芯片,在国内应该也属于行业首颗chiplet AI芯片。

在应用场景灵活性上,由于思元370在一颗芯片中封装2颗AI计算芯粒(MLU-Die),每一个MLU-Die都具备独立的AI计算单元、内存、IO以及MLU-Fabric控制和接口,不同MLU-Die可以组合规格多样化的产品,为用户提供适用不同场景的高性价比AI芯片。

在算力上,基于台积电 7nm 制程工艺、整体集成390亿个晶体管的思元370最大算力达到 256TOPS(INT8),相比上一代思元270算力直接翻倍。

不到18个月就实现了算力翻倍,在通用处理器领域已经失效的摩尔定律,在AI芯片领域还在延续。

造芯片,技术和市场各有多重要

算力翻倍究竟有多重要?

现实世界对于算力的需求远没有到达顶峰。以英伟达为例,自2017年底英伟达发布Tesla V100之后,训练最大模型的算力需求增长了3000倍。

举例来说,仅是分析3000万路视频,以常见的英伟达Tesla P4显卡为例约需100万块,总硬件成本200亿元以上,一块显卡按照75瓦起步功耗计算总功耗也高达7.5万千瓦。

通过如思元370这样更具效率的AI芯片在云端场景替代传统GPU,就能够大幅降低前期基础设施建设成本,减少后期运行能耗。

可以说,思元370成功推出的背后,不仅是寒武纪研发人员的日夜努力,也是社会各行各业对更高效率AI芯片的迫切需求。正如恩格斯所说,“社会一旦有技术上的需要,则这种需要就会比十所大学更能把科学推向前进”。

随着新一轮产业竞争与供应链争夺正在展开,对人工智能、数字化技术的需求只增不减。而各行各业更是向科创类产业企业界提出了前所未有的技术需求,在这种需求刺激下,AI创业企业的研发成果获得落地应用的机会更多,市场也更大。

乘风起势,市场的需求让AI芯片赛道涌入更多入局者,推动新技术的不断迭代,也让行业格局逐渐发生变动。

目前,英伟达在AI芯片领域仍具有最大的影响力。在全球云端训练芯片市场,英伟达基本是一家独大,其GPU+CUDA计算平台是应用最多的AI训练方案。在推理芯片领域,则呈现出百家争鸣的竞争生态,因为推理芯片更注重功耗、时延、成本等因素,且相比于训练芯片需求量更高,使用场景更广泛。

英伟达之外,英特尔、谷歌、IBM、AMD等巨头以及寒武纪等初创企业,都在AI芯片领域耕耘多年,并一步一步进行纵深研发。

市场只会留给有准备的人。寒武纪作为初创企业,对客户需求的把握也精细到全流程跟进。比如思元370,不仅可以作为推理芯片,也可以作为训练芯片使用。这样做的好处不仅是寒武纪自己的产品能够兼顾训练与推理,也方便客户全流程的模型部署、业务落地。

实际上,今年1月寒武纪发布的首颗训练芯片思元290,在训练为主的同时也可以进行推理。借助Cambricon Neuware软件栈提供的软件及应用生态,就可以在思元290芯片上实现图形图像、语音、NLP、搜索推荐等多种应用的训练和推理。

此次思元370发布,Cambricon Neuware进一步整合了训练和推理的全部底层软件栈,包括底层驱动、运行时库、算子库以及工具链等,将MagicMind和深度学习框架Tensorflow、Pytorch深度融合,实现训推一体。依托于训推一体,在寒武纪全系列计算平台上,从云端到边缘端,用户均可以无缝地完成从模型训练到推理部署的全部流程,进行灵活的训练推理业务混布和潮汐式的业务切换,加快了用户端到端业务落地的速度,减少模型训练研发到模型部署之间的繁琐流程,可快速响应业务变化,提升算力利用率,降低运营成本。

推理加速引擎MagicMind是寒武纪软件栈Cambricon Neuware全新升级的重要组成部分

图源:企业官网

在巨大的市场需求推动下,技术进步也愈加快速,硬件上翻倍甚至更多倍的增长比比皆是。比如今年1月发布的思元290,相比思元270就实现峰值算力提升4倍、内存带宽提高12倍、芯片间通信带宽提高19倍。

但硬件强只是起步,AI芯片企业更需要软件强。比如英伟达在AI芯片领域的强大,除了硬件性能之外,也因为其CUDA生态已经成为众多人工智能开发者主流选择,从而为自己造就了一条护城河。初创企业,同样需要建立自己的生态护城河。

云、边、端、车四位一体布局中的寒武纪优势

AI芯片龙头的优势,毋庸讳言。而寒武纪在最新的布局中,也显现出一家创业企业的独特优势。

在今年7月举办的2021世界人工智能大会上,寒武纪首次披露了控股子公司行歌科技的进展,并披露研发中的车载智能芯片关键数据——基于7纳米制程的车规级芯片,算力大于200TOPS,具备独立安全岛及成熟软件工具链。

据中国汽车工业协会数据,2020年中国汽车销量为2531.1万辆。假如未来10年汽车销量的规模继续维持在2500万辆左右,智能汽车渗透率能够达到50%,车载智能芯片单车价值达到5000元,那就是高达625亿元的市场规模。只是现在这一市场可能还不够大,但未来整个智能驾驶系统的市场规模一定会堪比手机SOC、云端AI芯片。

一方面,智能驾驶不仅是车载智能芯片的事情,未来的智能驾驶一定会涉及车路协同,通过路测的边缘端智能芯片实现实时收集、低延时传输道路与车辆、车辆之间的交互信息,将汽车本身获取不到的盲区、路侧、他车、超远距离、全路网实时信息告知汽车端,帮助单个汽车或者智能车队规划路线;边缘端传感器采集的许多数据还会回传至云端,利用云端智能芯片处理边缘端芯片难以处理的复杂训练、推理任务。

IDC半导体研究总监Michael J. Palma曾说:“在边缘系统中,神经网络做出的即时决策可以创造独特的价值,不受延迟和连接问题的约束——而这些问题对云解决方案来说是个挑战。”未来遍布路网的边缘端智能芯片,将成为智能驾驶完整系统不可或缺的组成部分。整个智能驾驶的实现,更需要“云边端车”四位一体的深度联动。

另一方面,寒武纪本身在云边端的AI处理器上已经有着有代表性的量产产品。2016年成立初期就以IP授权的形式打入高端智能手机终端市场,在终端智能处理器IP授权业务上一战成名之后,又迅速拓展云端业务,通过新业务提高了公司的核心竞争力和抗风险能力,成功规避了单一客户带来的波动影响。2019年底,寒武纪又发布了边缘AI系列芯片及加速卡产品,通过统一的软件开发平台,实现云边端无缝协同。

从“云边端一体化”走向“云边端车”四位一体,对智能驾驶行业来说是一种未来的必然趋势,对寒武纪自身来说则是一个自然的发展过程。

寒武纪的“云边端车”处理器都是用统一的处理器架构和基础软件平台,这意味着开发者只要在某一端应用寒武纪的产品,其他端很容易就能实现互相兼容,大大减少不同平台的开发和应用迁移成本。

寒武纪“云边端车”的协同优势,在目前国内车载智能芯片厂家中是较为独特的。

首先就是设计经验直接复用。国内智能驾驶芯片企业一般采用12纳米、14纳米、16纳米制程居多,行歌科技却起步就要做7纳米制程、200 TOPS以上算力。这种大算力、先进制程芯片,没有过7纳米制程经验的AI芯片企业是很难操作的,行歌科技的优势就在于可以直接复用母公司寒武纪的7纳米芯片设计经验。

其次,寒武纪的云端AI芯片属于通用型AI芯片(非通用处理器),具有通用的AI软件栈,客户可以根据需要方便移植或开发自己的算法。从云端芯片到车载芯片,芯片上要移植新的智能驾驶算法,这种通用型就能够避免行歌科技重新花大量的时间和精力去做适配工作。

第三,在车载AI芯片的车规级要求上,虽然寒武纪此前没有做过车规级产品,但从工业级到车规级,更多区别在于车规级的温度、振动、侵蚀、电磁兼容、可靠性、一致性、产品生命周期等要求更严格,对芯片设计本身而言结构变化并不大,拓展车载芯片的难度并不会高于此前从终端拓展到云端、边缘端。

一家企业能够不断拓展新的领域,且新领域具有足够的市场空间,值得新入局者来此施展手脚,那么市场格局的新变化就颇值得关注。

据了解,市面上具有“云边端车”生态协同优势的玩家,其实只有两三家,寒武纪正是其中之一。芯片领域一位投资人认为,车载智能芯片这一赛道在巨头之外还是容得下五六家初创芯片公司,最终可能会有三家初创公司胜出,寒武纪或许也会是其中之一。

等待下一个必然中的爆发期

从2016年成立至今,寒武纪智能芯片的架构已经更迭了四代。

比如最新的第四代智能处理器架构MLUarch03,拥有新一代张量运算单元,内置Supercharger模块大幅提升各类卷积效率;采用全新的多算子硬件融合技术,在软件融合的基础上大幅减少算子执行时间;片上通讯带宽是上一代MLUarch02的2倍、片上共享缓存容量最高是MLUarch02的2.75倍。配合最新架构,寒武纪还推出全新MLUv03指令集,更完备,更高效且向前兼容。

寒武纪智能芯片架构演进

图源:企业官网

以每一代的架构为基础,都可以开发出适合不同端的IP、芯片矩阵。而每一款芯片,又都会分成不同组件,比如按照十几个组件设立十几个研发小组,每个小组来做一个组件,最后把组件拼起来形成智能芯片。不同的小组可以根据项目需求,对组件进行多种组合、拼接,并实现不同芯片功能组件上重叠部分的高效复用。

一方面,这就使得云、边、端、车不同芯片拥有很多可以复用的组件与设计,让“云边端车”协同优势成为可能;另一方面,这也使得过去的积累不会因为业务线变化而浪费,哪怕是现在总营收占比已经很小的IP授权业务,对于其他覆盖面更多的业务线,仍然有着生态拓展、技术复用的价值,比如在边缘侧智能芯片设计上复用。

作为国内AI芯片领域的先发者,先发者总要先去踩坑,但走过的每一步,都算数。

寒武纪展示给外界的架构更迭,一代又一代,是清晰而确定的。但每一代架构更迭的背后,并不是一个重复造不同轮子的过程。

从思元100到思元270再到新品思元370的技术跃迁和时间线来看,芯片架构设计师刚完成这一代就要着手下一代,永远是滚动推进的过程。寒武纪芯片架构设计师需要一直关注国际最前沿的芯片设计、算法,让寒武纪的智能芯片能够高效适配未来可能的流行算法,但这也不意味着前一代架构就要立即被取代。事实上,这也是国际顶尖芯片企业所采用的研发策略。

在外界看来,一代接着一代是分段的。但对于寒武纪来说,每一代架构之间都是互相勾连、镶嵌、攒接的,虽然每更新一代处理能力提升、效率优化都很大,但代际之间并非替代关系,而是适配不同的市场,从而实现资源的最大化利用。比如思元370和思元290之间就不是替代的关系,因为前者主要是推理芯片,后者主要是训练芯片,两者是互补的关系。

AI芯片的构建很像搭积木,很多企业会使用ARM的内核,这相当于用乐高的积木搭建模型,巨头生产好了积木,企业只需要搭模型就好。但寒武纪用的是自研内核架构、自研指令集,相当于自己不仅要搭建模型还要生产积木,虽然拥有更高的自主性,但也增加了研发的成本。

最新公布的寒武纪三季报显示,前三季度公司主营收入2.22亿元,同比上升41.19%;归母净利润-62945.85万元,同比下降103.37%;前三季度研发费用4.33亿元,同比增长32.78%;销售毛利率为50.75%,属于芯片类企业正常水准。

研发费用上,尽管已经超过了营收,但在巨头同样投入很多研发的情况下,为了维持技术和产品的领先,寒武纪的研发仍然难以压缩。

如何看待寒武纪未来发展,其实和巨头能否通吃一切一样,是同一个问题的两个面。

如果未来巨头通吃一切,那创业企业自然都要消亡。而只要巨头无法通吃一切,AI芯片的市场份额中必然就会有头部创业企业的一份。

实际上,创业企业依然在不断涌入AI赛道、AI芯片赛道。

今年3月,全球电子技术知名媒体集团Aspencore发布的“中国IC设计100家排行榜”中,寒武纪入选AI芯片公司Top10。在美国著名半导体杂志《EETimes》发布的2021年“Silicon100”电子和半导体创业公司榜单,新上榜了9家中国企业。CB Insights最新的AI in Numbers报告也显示,今年第二季度AI初创公司获得的投资总量超过200亿美元,创历史新高。

在很多国内行业观察者看来AI芯片企业已经处于低谷之时,全球范围内对AI企业的看好与投资其实依然处于高峰期。初创AI芯片企业SambaNova 6月获得6.76亿美元投资,Graphcore、Groq、Scale AI等也都是AI芯片领域的热门企业。

尽管初创企业都会面对巨头英伟达的阴影,但目前市值已经突破7000亿美元的英伟达,在短短5年前其实还只是一家不到500亿美元市值的不被看好的衰落企业。哪怕英伟达这样的巨头,发展史也是波动起伏的历史,在熬死和打败其他的巨头和初创企业之后,等到了AI计算的大爆发,最终成为了一个目前任何人都无法绕过的巨头。

相比于巨头,寒武纪目前依然是一家低调的初创企业。思元370很早就开始设计,2020年三季度完成流片,今年二季度完成封装、测试,部分客户已完成测试、导入,据悉在语音、视觉等场景的性能表现超出客户预期,浪潮、阿里云、百度、招商银行等客户均给出了积极评价,但这些信息直到发布才告诉外界。

专业分工是成熟产业链的特征,只要寒武纪能够保持“理工男”的朴素作风,持续在架构保持前瞻性,市场就不缺机会。

巨头不可能吃掉所有市场,巨头不可能所有场景都自研,巨头也不会购买竞对巨头的芯片产品。那么多初创企业进入AI芯片赛道,正是看中了巨头与巨头之间庞大的市场空间。

在AI芯片保持技术先进性的寒武纪,也会像等待到AI计算大爆炸的英伟达一样,遇到自己的爆发期。

正如寒武纪创始人陈天石所说:“作为一家中立的芯片公司,我们走最正统的芯片设计公司的路径,把应用场景留给人工智能行业的客户,而我们自己做大家的垫脚石。”

您可能也感兴趣:

今日热点

为您推荐

小康股份回应与华为关系及未来规划

“低首付”丰田金融服务让有车生活触手可及

万亿新赛道,未势能源A轮融资9亿,再掀起氢能投资热!

排行

- 腾龙股份股东王柳芳减持302.01万股 价格区间为14.81-15.90元/股

- 因个人资金需要 新泉股份实际控制人唐志华拟减持不超1124.54万股

- 信捷电气股东邹骏宇减持50万股 价格区间为60.41-67.50元/股

- 国家卫健委:湖北以30个省外新增病例17例

- 因自身资金需求 科森科技股东徐宁拟减持不超3.71万股公司股份

- 中公高科股东潘玉利减持50万股 价格区间为20-20.60元/股

- 多地患者治愈后“复阳” 对疫情防控提出新挑战 五大焦点权威解析

- “精诚合作,打赢这一仗!”

- 生态环境部:自1月20日以来全国已累计处置医疗废物12.3万吨 ...

- 承诺两年扭转乱象 银保监会加快推进意外险费率市场化改革 ...

精彩推送

- 斑马家政云完成8千万元A+轮融资,重新定义家政行业

- 蔚小理冲破魏建军的“长城”?

- 大厂为什么都想做“种草”?

- 福建矿业大佬凶猛

- 首发 | 「街景梦工厂」完成近亿元A+轮融资,这条6000亿赛道开始升温

- 看完这些过年大动作,我想回老家当土狗

- 北京城市副中心产业引导基金 子基金及子基金管理人投资筛选标准

- 网传盒马独立融资,生鲜的资本故事还丰满吗

- 网约车大战重启,乱象重出江湖

- 国产车企都在混什么?

- 春节档神仙打架,利好哪些上市公司

- 作业帮受邀出席稀土开发者大会 分享服务治理探索和落地实践

- 《梅艳芳》拯救香港影市

- 北京城市副中心产业引导基金设立,规模50亿元

- 28家企业完成融资,近百家资本涌入,医美上游谁是最强王者

- 快手春节活动分22亿红包,官方公布总冠方营销玩法

- 百货商场谋转型,“购物中心化”成趋势

- 《开端》开了个好头吗

- 作业帮推出智能硬件“小鹿写字笔”,黑科技提升孩子写字素养

- 当男生贴起面膜,VC赶来了

- “碳中和”成热点,拖鞋、玩具和汽车配件公司都要做光伏

- 祛魅元宇宙:一文看懂的投资逻辑和哲学思考

- 字节再变阵,「代理人」战争终结

- 快递价格战结束了吗

- 手握年轻人的B站,却握不住未来

- 辛巴们梦碎起步股份

- 微软买暴雪要弄元宇宙,任天堂不Care

- 砸下687亿美元,拥有COD的微软能挑战腾讯和索尼吗

- 动视暴雪为何价值687亿美元,元宇宙诸神之战开启

- 首发|儿童健康鲜食品牌「唯鲜良品」获峰瑞资本投资

- 字节裁撤投资业务,腾讯投资合伙人退出多家法人,蚂蚁减持众...

- B站的审核员不够用了

- 微软收购暴雪,等于张无忌学会太极拳

- 散户神坛变“祭坛”,Robinhood的危机才刚刚开始

- 红杉中国,一只罕见新基金诞生

- 过气韩束,能撑起上美IPO吗

- 贴身肉搏 午餐肉打响铁盒之战

- OKAI完成近亿元首轮融资,中金汇融基金领投

- 72小时筹集4000万美元,Web3.0到底是什么

- 华菱精工3名股东合计减持215.5万股 价格区间为11.82-11.82元/股

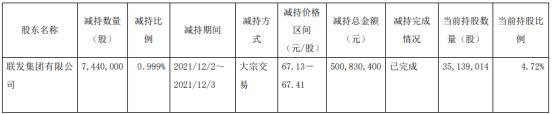

- 宏发股份股东联发集团减持744万股 价格区间为67.13-67.41元/股

- 凤形股份股东陈晓减持127.76万股 价格区间为24.03-28.92元/股

- 中船应急股东七一九所减持1921.17万股 套现1.9亿元

- 国泰君安发行30亿元短期融资券 兑付日为2022年12月8日

- 抖音盒子,起步艰难

- 暴利的精酿啤酒,却长不出巨头

- 2021在线教育:收缩、溃败与转型

- 雪崩前,微软为何肯豪掷近700亿美金

- 钱大妈生鲜败走北京

- 这个赛道迎来倒闭潮:小米也没干好

- 潮流消费俘获Z世代

- TPG旗下诺威健康完成7.6亿美元新融资,估值30亿美元

- 互联网,不能失去投资的力量

- 字节战投部裁撤,创投圈再无巨头接盘侠?

- 字节跳动解散战略投资部,互联网大厂告别赢者通吃时代

- 15天搭建一条特色商业街,街景梦工厂完成近亿元A+轮融资

- 33岁「退休」的中国外卖教父,又准备大干一场

- 美妆新零售品牌「HARMAY話梅」完成近2亿美元C轮及D轮融资

- 「双减」后的首个寒假,什么变了

- 钱大妈加盟扩张存在模式缺陷

- 快递行业要变了

- 新「赌城」宁德,隔壁温州都要抄作业

- 中国人已经实现“牛排自由”了吗

- 600亿婚纱摄影市场,互联网的蛮荒地

- 咖啡下沉,蜜雪冰城跟瑞幸抢生意

- 那些新消费品牌决定去播客

- 葡萄酒2021:从效仿到去欧洲化,如何品出新口味

- 8成收入依赖肉干,北交所宠物食品第一股成色几何

- 山西长治市潞城区设立亿元规模人才创业基金

- 盲盒离「熄火」还远

- 微软收购动视暴雪,走不出的IP战争

- 东南亚物流战事:守望最后一公里的Ninja Van

- 被“小视”的锅圈正在提升新一代的做饭效率

- 又一上市公司参投产业基金,规模1.5亿

- 瑞幸,是不是精品咖啡的搅局者

- 创立十年,国药资本今天正式更名

- 央视再曝光,低价财商课为何成了打不死的小强

- 共享充电宝的2021:高光、震荡与新的变量

- 游戏史上最大收购,微软687亿美元收购动视暴雪,加码元宇宙

- 800刀七天MBA速成班,打工人的「逆袭班」

- 团车造车,王多鱼看了都说好

- 又一个外国巨头倒下了,在中国只剩回忆杀

- 7个月连获3轮,新锐护肤品牌「C咖」完成SIG领投B轮融资

- 首只“高校+政府+产业”基金启动投资 华德诚志重科技基金加...

- 扇贝游回獐子岛了 ?

- 9元喜茶,如何为600亿估值「造梦」

- 泉州交通发展产业母基金正式备案,规模百亿

- 獐子岛为何荒唐涨停

- 字节跳动大力布局文娱,短期内能变现吗

- “车企创始人骂街第一人”又开炮了

- 687亿美元惊天大收购:动视暴雪服软了

- 微软花687亿买下暴雪一具空壳

- 2021,爱奇艺无能为力

- 「柏全生物」宣布完成数千万天使轮融资,上海生物医药基金领投

- 运达科技2021年预计净利9695.47万-1.29亿元 同比下降超两成

- 赣能股份2021年预计亏损2.17亿-3.2亿元 同比由盈转亏

- 汇纳科技股东减持425.46万股 套现7190.22万元

- 海联金汇副总裁周建孚辞职 第三季度净利润为7739万元

- 开尔新材控股股东吴剑鸣质押2000万股 第三季度净利润为3432万元

- 首都在线控股股东曲宁质押1633万股 第三季度净利润为343万元

营业执照公示信息

营业执照公示信息